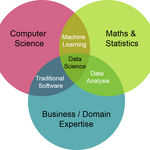

Elegir un algoritmo de aprendizaje automático apropiado es un paso crítico en el desarrollo de cualquier proyecto basado en datos. Con el aumento del big data, el aprendizaje automático se ha convertido en una herramienta indispensable para resolver una amplia gama de problemas.

Desde el procesamiento del lenguaje natural y el reconocimiento de imágenes hasta la detección de fraudes y la predicción de la rotación de clientes.

Sin embargo, con tantos algoritmos disponibles, puede resultar difícil seleccionar el adecuado para un problema dado.

El proceso de selección de un algoritmo de aprendizaje automático implica varias consideraciones, incluyendo la naturaleza del problema, los datos disponibles, los resultados deseados y las restricciones del proyecto.

Cada algoritmo tiene sus fortalezas y debilidades, y la elección del algoritmo dependerá de los requisitos específicos del proyecto. Por lo tanto, es esencial tener una buena comprensión de los diversos algoritmos disponibles, sus pros y contras y los tipos de problemas que son más adecuados para resolver.

¿Cómo elegir un algoritmo de aprendizaje automático?

Aquí hay algunos pasos que pueden ayudar a guiar su decisión y elegir el mejor algoritmo para su problema de negocio:

Aquí hay algunos pasos que pueden ayudar a guiar su decisión y elegir el mejor algoritmo para su problema de negocio:

1- Definir el problema: A la hora de elegir un algoritmo de aprendizaje automático, el primer paso es definir el problema que intenta resolver. Tiene que determinar si su problema entra dentro de una de las tres categorías principales del aprendizaje automático: clasificación, regresión o agrupación.

La clasificación se utiliza cuando se quiere predecir un resultado categórico, como la probabilidad de que un cliente se dé de baja o no. La regresión se utiliza cuando se quiere predecir un valor numérico, como el precio de una casa. La agrupación se utiliza cuando se desea agrupar puntos de datos similares, como los clientes en función de su comportamiento de compra.

Si identifica el tipo de problema que se le plantea, podrá reducir la lista de algoritmos adecuados. Cada tipo de problema requiere un enfoque diferente, por lo que es importante elegir un algoritmo que esté específicamente diseñado para abordar su problema.

2- Comprender los datos: Antes de elegir un algoritmo de aprendizaje automático, es fundamental examinar detenidamente los datos. Al analizar los datos, puede obtener información sobre sus características e identificar algoritmos que funcionen bien con sus datos específicos.

Un aspecto importante a tener en cuenta es el número de características de los datos. Las características son las propiedades medibles que describen los datos y pueden tener un impacto significativo en el rendimiento del algoritmo. Es importante saber cuántas características tiene y cómo se relacionan entre sí.

Otro aspecto a tener en cuenta es la presencia de valores perdidos en los datos. Los valores perdidos pueden causar problemas a algunos algoritmos, y es importante saber cómo tratarlos adecuadamente. También es esencial analizar la distribución de la variable objetivo, que es la variable que se intenta predecir. Comprender la distribución puede ayudarle a seleccionar un algoritmo adecuado para su problema específico. Por último, es importante examinar las relaciones entre las características de los datos. Algunos algoritmos funcionan mejor con características muy correlacionadas, mientras que otros lo hacen mejor con características no correlacionadas. Comprender estas relaciones puede ayudarle a identificar el mejor algoritmo para sus datos. Si dedica tiempo a comprender las características de sus datos, podrá elegir el algoritmo que mejor se adapte a su problema específico y obtener resultados más precisos y significativos.

3- Complejidad y rendimiento: A la hora de elegir un algoritmo de aprendizaje automático, es importante tener en cuenta el equilibrio entre complejidad y rendimiento. Por un lado, los algoritmos más sencillos suelen ser más fáciles de entender e interpretar, lo que puede ser beneficioso si necesita explicar sus resultados a otras personas o desea obtener información sobre los patrones subyacentes en sus datos. Sin embargo, los algoritmos más sencillos pueden no ser capaces de captar relaciones más complejas en los datos, lo que podría limitar su rendimiento.

Por otro lado, los algoritmos más complejos pueden ofrecer un mayor rendimiento al ser capaces de captar relaciones más intrincadas en los datos. Sin embargo, estos algoritmos pueden ser más difíciles de implementar y pueden requerir más recursos computacionales, lo que puede ralentizar el proceso de desarrollo o requerir un hardware más potente.

La clave está en encontrar un equilibrio entre simplicidad y rendimiento que se adapte a sus necesidades específicas. A la hora de elegir un algoritmo, tenga en cuenta la complejidad del problema, los recursos disponibles y los resultados deseados. Recuerde que no existe una solución única, así que esté dispuesto a experimentar con diferentes algoritmos y enfoques para encontrar el que mejor se adapte a su proyecto.

4- Tiempo y recursos de formación: A la hora de elegir un algoritmo de aprendizaje automático, es importante tener en cuenta el tiempo y los recursos necesarios para el entrenamiento. Algunos algoritmos requieren mucha potencia de cálculo y tiempo de entrenamiento, lo que puede suponer una limitación importante si se dispone de recursos limitados. En estos casos, puede ser necesario dar prioridad a los algoritmos que puedan entrenarse de forma más eficiente, aunque no sean los más sofisticados o precisos.

Pero esto no significa necesariamente que haya que renunciar a la calidad. A veces, los algoritmos más sencillos pueden ser más eficientes y eficaces para determinados tipos de problemas. Todo depende de la naturaleza de los datos y del problema concreto que se intente resolver.Cuando evalúe diferentes algoritmos de aprendizaje automático, asegúrese de tener en cuenta el tiempo y los recursos necesarios para el entrenamiento. Esto te ayudará a tomar una decisión más informada sobre qué algoritmo es el más adecuado para tu proyecto, y asegurarte de que estás aprovechando al máximo tus recursos disponibles.

5- Ajuste los hiperparámetros: Cuando se trata de algoritmos de aprendizaje automático, a menudo hay muchos parámetros que se pueden ajustar para mejorar el rendimiento. Estos parámetros se denominan hiperparámetros y pueden tener un gran impacto en la precisión y eficacia del modelo.

Los hiperparámetros pueden incluir cosas como la tasa de aprendizaje, la intensidad de la regularización, el número de capas ocultas en una red neuronal, y más. La clave está en experimentar con diferentes ajustes para encontrar la mejor combinación para su problema específico.

Este proceso se conoce como ajuste de hiperparámetros, y puede llevar mucho tiempo y requerir algo de ensayo y error. Sin embargo, es un paso importante para garantizar que el modelo funcione al máximo.

Algunos métodos populares para el ajuste de hiperparámetros son la búsqueda en cuadrícula, la búsqueda aleatoria y la optimización bayesiana. Estas técnicas pueden ayudarle a explorar sistemáticamente diferentes combinaciones de hiperparámetros para encontrar el conjunto óptimo.

En resumen, el ajuste de hiperparámetros es una parte crucial del proceso de aprendizaje automático, ya que puede mejorar significativamente la precisión y el rendimiento de su modelo. Experimentando con diferentes configuraciones y utilizando técnicas como la búsqueda en cuadrícula y la búsqueda aleatoria, puede encontrar la mejor configuración de hiperparámetros para su problema.

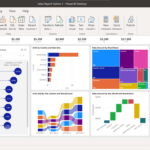

6- Evaluar y comparar: Una vez que hayas seleccionado unos cuantos algoritmos de aprendizaje automático adecuados para tu problema, es hora de evaluar y comparar su rendimiento. El proceso de evaluación implica dividir los datos en conjuntos de entrenamiento y de prueba o utilizar técnicas de validación cruzada para asegurarse de que el modelo no se ajusta en exceso a los datos.

Para evaluar el rendimiento de cada algoritmo, puede utilizar métricas apropiadas como la exactitud, la precisión, la recuperación, la puntuación F1 u otras. Estas métricas le ayudarán a determinar el rendimiento de su modelo y qué algoritmo se ajusta mejor a su problema específico.

Es importante tener en cuenta que ningún algoritmo es universalmente el mejor para todos los problemas. Por eso es crucial comparar el rendimiento de varios algoritmos y elegir el que mejor se adapte a su caso de uso específico.

Siguiendo estos pasos y seleccionando el mejor algoritmo para su proyecto de aprendizaje automático, estará en camino de crear modelos precisos y eficaces que pueden ayudarle a resolver una amplia gama de problemas, desde el procesamiento del lenguaje natural y el reconocimiento de imágenes hasta la detección de fraudes y la predicción de la pérdida de clientes.

Algoritmos populares de aprendizaje automático

Algunos algoritmos populares de aprendizaje automático para diferentes tipos de problemas incluyen:

Clasificación:

Los algoritmos de aprendizaje automático pueden clasificarse en diferentes categorías en función del tipo de problema que resuelven. Uno de los tipos de problemas más comunes es la clasificación, cuyo objetivo es predecir la clase o categoría de una observación dada basándose en sus características.

En este contexto, existen varios algoritmos populares que los científicos de datos utilizan para construir modelos predictivos. Echemos un vistazo a algunos de ellos:

- Regresión logística: Este algoritmo se suele utilizar en problemas de clasificación binaria (en los que sólo hay dos resultados posibles) y su objetivo es encontrar el mejor límite de decisión que separe las dos clases. Funciona calculando la probabilidad de que una muestra pertenezca a una clase determinada y haciendo una predicción basada en esa probabilidad.

- Árboles de decisión: Un árbol de decisión es una estructura similar a un diagrama de flujo en la que cada nodo representa una decisión o una prueba sobre una característica, y cada rama representa los posibles resultados. Los árboles de decisión se utilizan habitualmente en problemas de clasificación y regresión y son fáciles de interpretar y visualizar.

- Bosques aleatorios: Los bosques aleatorios son un método conjunto que combina varios árboles de decisión para mejorar la precisión y reducir el sobreajuste. Cada árbol del bosque se entrena con un subconjunto diferente de datos y la predicción final se obtiene promediando las predicciones de todos los árboles.

- Máquinas de vectores soporte (SVM): La SVM es un potente algoritmo que puede utilizarse tanto para problemas de clasificación lineales como no lineales. Funciona encontrando el hiperplano que mejor separa las dos clases al tiempo que maximiza el margen entre las clases.

- Naive Bayes: Naive Bayes es un algoritmo sencillo y rápido que funciona bien para la clasificación de texto y el filtrado de spam. Calcula la probabilidad de cada clase a partir de las características de entrada y selecciona la clase con la probabilidad más alta.

- Vecinos más próximos (k-NN): Este algoritmo se basa en la idea de que las muestras que están próximas en el espacio de características tienen más probabilidades de pertenecer a la misma clase. Busca los k vecinos más próximos a una muestra y hace una predicción basada en sus etiquetas de clase.

- Redes neuronales: Las redes neuronales son una clase de algoritmos potentes y flexibles que pueden utilizarse para una amplia gama de problemas de clasificación. Se inspiran en la estructura y función del cerebro humano y pueden aprender patrones complejos en los datos mediante un proceso de entrenamiento en un gran conjunto de datos.

Regresión:

En el aprendizaje automático, los algoritmos de regresión se utilizan para predecir un valor numérico continuo. Esto puede ser útil en diversas aplicaciones, como la predicción de los ingresos por ventas o la estimación de los precios de la vivienda. Existen varios tipos de algoritmos de regresión, cada uno con sus propios puntos fuertes y débiles.

- Clasificación Lineal: Este es un algoritmo sencillo que modela la relación entre una variable dependiente y una o más variables independientes mediante una ecuación lineal. Se utiliza comúnmente para predecir valores numéricos, como precios o cantidades. Regresión Ridge: Esta es una técnica de regularización que agrega un término de penalización a la ecuación de regresión lineal para evitar el sobreajuste. Funciona reduciendo los coeficientes de las variables independientes hacia cero.

- Regresión Lasso: Al igual que la regresión Ridge, Lasso es una técnica de regularización que agrega un término de penalización a la ecuación de regresión lineal. Sin embargo, en Lasso, el término de penalización es el valor absoluto de los coeficientes, lo que puede resultar en que algunos de ellos sean exactamente cero. Esto hace que Lasso sea una herramienta útil para la selección de características.

- Elastic Net: Elastic Net es una combinación de las regresiones Ridge y Lasso. Agrega tanto las penalizaciones L1 como L2 a la ecuación de regresión lineal, lo que puede resultar en un modelo escaso con algunos coeficientes exactamente iguales a cero.

- Árboles de Decisión: Los árboles de decisión son un algoritmo no paramétrico que se puede utilizar tanto para problemas de regresión como de clasificación. Funcionan dividiendo recursivamente los datos en subconjuntos según los valores de las variables independientes y luego realizando una predicción en función de la clase mayoritaria o el valor medio de la variable objetivo en cada subconjunto.

- Bosques Aleatorios: Los bosques aleatorios son un método de conjunto que combina múltiples árboles de decisión para mejorar el rendimiento y reducir el sobreajuste. Funcionan creando una gran cantidad de árboles de decisión utilizando diferentes subconjuntos de los datos y subconjuntos seleccionados aleatoriamente de las características.

- Regresión Vectorial de Soporte: La regresión vectorial de soporte es un tipo de algoritmo de regresión que utiliza máquinas de vectores de soporte para encontrar un hiperplano que se ajuste mejor a los datos. Funciona minimizando la suma de los errores entre los valores predichos y reales, sujeto a un margen de tolerancia.

- Redes Neuronales: Las redes neuronales son una clase de algoritmos que se inspiran vagamente en la estructura y función del cerebro humano. Consisten en nodos interconectados o “neuronas” que procesan información y realizan predicciones. Las redes neuronales se pueden utilizar para una amplia gama de problemas, incluyendo regresión, clasificación y reconocimiento de imágenes.

Agrupación:

El clustering es un tipo de problema de aprendizaje automático que implica agrupar puntos de datos similares en conjuntos o segmentos. A menudo se utiliza en tareas como la segmentación de clientes, la detección de anomalías y la segmentación de imágenes.

- El algoritmo k-Means es simple y rápido, y funciona bien para conjuntos de datos esféricos. Funciona asignando cada punto de datos al centroide de cluster más cercano y luego actualizando el centroide en función de los puntos de datos asignados.

- DBSCAN es un algoritmo basado en la densidad que puede encontrar grupos de formas arbitrarias. Funciona identificando regiones de alta densidad y conectándolas para formar grupos.

- Agglomerative Clustering es un algoritmo jerárquico que comienza tratando cada punto de datos como un cluster separado y luego fusiona recursivamente pares de clusters hasta que se cumple un criterio de parada. Puede usarse para crear grupos de diferentes tamaños y formas.

- Mean Shift es un algoritmo no paramétrico que funciona mediante el desplazamiento iterativo del centroide de cada cluster hacia la región de mayor densidad. Puede usarse para identificar grupos de diferentes tamaños y formas.

- Los Modelos de Mezclas Gaussianas (GMM) son un algoritmo probabilístico que modela cada cluster como una distribución Gaussiana. Puede usarse para identificar grupos con diferentes formas y orientaciones.

A la hora de elegir un algoritmo de clustering, es importante tener en cuenta factores como la naturaleza de los datos, el número y la forma deseados de los clusters y los recursos informáticos disponibles.

Recuerde que ningún algoritmo es universalmente el mejor para todos los problemas. Es importante experimentar con diferentes algoritmos y configuraciones para encontrar el que mejor se adapte a su caso de uso específico.

Conclusión

Como conclusión general, seleccionar el algoritmo de aprendizaje automático adecuado es un paso crucial en cualquier proyecto empresarial basado en datos. Con la abundancia de algoritmos disponibles, puede resultar complicado elegir el más adecuado para un problema determinado.

Sin embargo, si se sigue un enfoque sistemático que incluya la definición del problema, la comprensión de los datos, la consideración de la complejidad y el rendimiento, el tiempo y los recursos de formación, el ajuste de los hiperparámetros y la evaluación y comparación de algoritmos, es posible tomar una decisión informada.

Es esencial recordar que ningún algoritmo se adapta perfectamente a todos los problemas, y que es necesario experimentar con distintos algoritmos y configuraciones para encontrar el que mejor funcione para un caso de uso específico.

Puedes ver más artículos de interés en nuestro blog.