En este articulo vamos a analizar una pregunta muy interesante ¿Se puede hackear la inteligencia artificial?

La inteligencia artificial (IA) suele basarse en sistemas basados en software que pueden aprender y tomar decisiones a partir de datos que pueden tener distintas fuentes.

La aplicación de estos sistemas (correctamente) tiene el potencial de transformar muchas industrias, desde la sanidad a las finanzas o el transporte. Pero, como cualquier software/hardware/sistema, las soluciones de IA son vulnerables a los ataques de los piratas informáticos.

Hackeando una inteligencia artificial

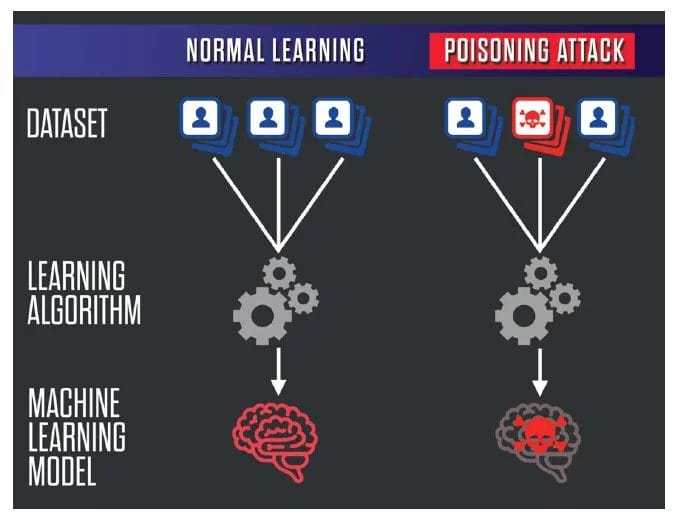

Una de las formas principales, y más utilizadas, en que los sistemas de IA pueden ser atacados es a través de lo que generalmente se define como envenenamiento de datos o Data Poisoning. El envenenamiento de datos implica la manipulación de los datos utilizados por la IA para ser entrenada con el fin de afectar a las futuras decisiones que tomará. Por ejemplo, un atacante podría insertar datos incorrectos o engañosos en un conjunto de datos utilizado para entrenar un sistema de detección de fraudes, con el fin de hacer que el sistema no detecte transacciones fraudulentas.

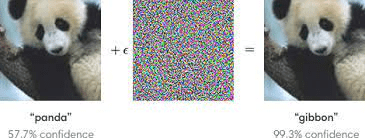

Otra forma de atacar los sistemas de IA es mediante ataques adversarios. Estos ataques consisten en añadir pequeñas cantidades de ruido o distorsión a una entrada, como una imagen o un archivo de audio, con el fin de engañar a un sistema de IA para que lo clasifique erróneamente.

Por ejemplo, un atacante puede añadir pequeñas distorsiones a una señal de stop en una imagen para que un vehículo autónomo la clasifique erróneamente como una señal de ceda el paso.

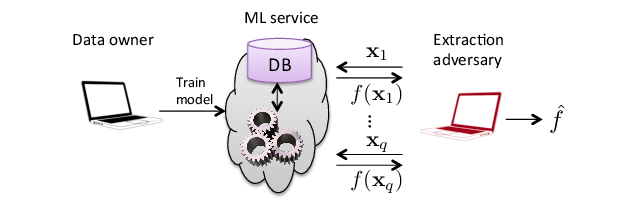

Los sistemas de IA también pueden ser atacados mediante el robo de modelos, que consiste en aplicar ingeniería inversa a un modelo de aprendizaje automático para robarlo. Esto puede hacerse utilizando consultas al modelo y analizando las respuestas, con el fin de deducir cómo funciona el modelo.

Por último, pero no por ello menos importante, los sistemas de IA pueden ser atacados a través de la inversión de modelos, que consiste en utilizar la salida de un sistema de IA para invertir la ingeniería de la entrada.

Por ejemplo, un atacante podría utilizar la salida de un sistema de diagnóstico médico para deducir el historial médico o el estado de salud de un paciente.

¿Como proteger la inteligencia artificial?

Para hacer frente a estos riesgos de seguridad, es importante diseñar los sistemas de IA teniendo en cuenta la seguridad desde el diseño y a través del uso de los datos, en lo que podríamos llamar seguridad por diseño, confianza cero y enfoque centrado en los datos.

Esto incluye la aplicación de fuertes medidas de seguridad como el cifrado, los controles de acceso y los sistemas de detección de intrusos. También implica diseñar sistemas de IA transparentes y explicables, de modo que sea más fácil identificar cuándo se ha manipulado o puesto en peligro el sistema.

Además, en lugar de adoptar únicamente medidas reactivas, hay varias medidas preventivas y de seguridad que pueden tomarse para mejorar la protección de los sistemas de IA frente a los ataques, como:

- Calidad y validación de los datos: Una de las mejores formas de protegerse contra los ataques de envenenamiento de datos es asegurarse de que los datos utilizados para entrenar los sistemas de IA sean de alta calidad y estén validados exhaustivamente. Para ello se pueden utilizar técnicas como la limpieza de datos, la creación de perfiles de datos y la verificación de datos.

- Actualizaciones y parches periódicos: es importante mantener los sistemas de IA al día con los últimos parches y actualizaciones de seguridad, con el fin de protegerse contra las vulnerabilidades que pueden ser explotadas por los atacantes.

- Cifrado y controles de acceso: Los sistemas de IA deben diseñarse con fuertes controles de acceso y cifrado, con el fin de proteger contra el acceso no autorizado o la manipulación. Esto puede incluir técnicas como el cifrado de datos en reposo y en tránsito, controles de acceso basados en funciones y permisos, y autenticación multifactor.

- Detección predictiva de intrusiones y respuesta: Los sistemas de IA deben estar equipados con capacidades de detección y respuesta a intrusiones con capacidad predictiva, con el fin de detectar y responder a los ataques en tiempo real. Esto puede incluir técnicas como el análisis de registros, la supervisión del tráfico de red y la detección de anomalías.

- Explicabilidad y transparencia de los modelos: Los sistemas de IA deben diseñarse para ser transparentes y explicables, de modo que sea más fácil identificar cuándo se ha manipulado o comprometido el sistema. Esto puede incluir técnicas como la interpretabilidad del modelo, la transparencia algorítmica y la detección de sesgos.

- Supervisión e intervención humanas: Por último, es importante contar con la supervisión e intervención humanas para supervisar y controlar el comportamiento de los sistemas de IA. Esto puede incluir técnicas como los sistemas “human-in-the-loop”, la toma de decisiones automatizada con revisión humana y los marcos éticos de la IA.

Conclusiones

En resumen, hay varias medidas preventivas y de seguridad que pueden adoptarse para proteger los sistemas de IA de los ataques. Entre ellas se incluyen garantizar la calidad y validación de los datos, actualizaciones y parches periódicos, encriptación y controles de acceso, detección y respuesta ante intrusiones, explicabilidad y transparencia de los modelos, y supervisión e intervención humanas. Mediante la aplicación de estas medidas, las organizaciones pueden ayudar a proteger sus sistemas de IA de los ataques y garantizar su seguridad.

En resumen, hay varias medidas preventivas y de seguridad que pueden adoptarse para proteger los sistemas de IA de los ataques. Entre ellas se incluyen garantizar la calidad y validación de los datos, actualizaciones y parches periódicos, cifrado y controles de acceso, detección y respuesta ante intrusiones, explicabilidad y transparencia de los modelos, y supervisión e intervención humanas. Mediante la aplicación de estas medidas, las organizaciones pueden ayudar a proteger sus sistemas de IA de los ataques y garantizar su seguridad.

Para más artículos sobre inteligencia artificial no te olvides de volver al blog de forma regular para nuevos contenidos.